| 創澤機器人 |

| CHUANGZE ROBOT |

隨著自然語言處理技術的發展以及客戶需求的提高,當機器人進入以人為主的環境時,必須學會理解人類語言,完成指定任務。相較于傳統只對場景做出反應的機器人操作方法,結合語義輸入,讓機器人理解人類語言,根據場景和自然語言指令完成相應任務,能為人機協作帶來更大的便利性。然而,目前該方法具有如下限制:

(1)依賴手工編碼任務符號來實現語義表達,限制了語義層面的泛化性。

(2)從指令中推斷動作序列時,需要密集的子目標監督。

(3)缺乏更深層次的以目標為中心的推理方法,在解釋復雜指令時不連貫。

針對上述問題,該文章提出了一種可感知視覺場景,同時處理語言輸入的端到端可訓練的模型。該模型使用視覺輸入得到當前場景中物體在初始狀態下的位置關系,以語義文字推理目標狀態下對應的位置關系,實現由自然語言引導機器人進行技能操作。 相關成果以“Learning Neuro-symbolic Programs for Language Guided Robot Manipulation”為題發表于International Conference on Robotic and Automation (ICRA)會議中。

該文章提出了一種新型神經符號模型,使用自然語言推理目標場景,實現在給定初始場景和目標場景的情況下即可學習執行復雜的操作任務,并展示了如何在不需要任何中間監督的情況下,僅使用初始與目標兩個場景作為監督來獲取機器人操作動作的密集表示。 實驗表明,該文章的方法可通過端到端的訓練而不需進行任何子目標監督,即可展現出強大的指令理解能力,并對新場景和指令展現出強大的泛化能力,為將來基于自然語言的人機協作,機器人的語義指令集的拓展提供了新的參考思路。

1、模型結構設計

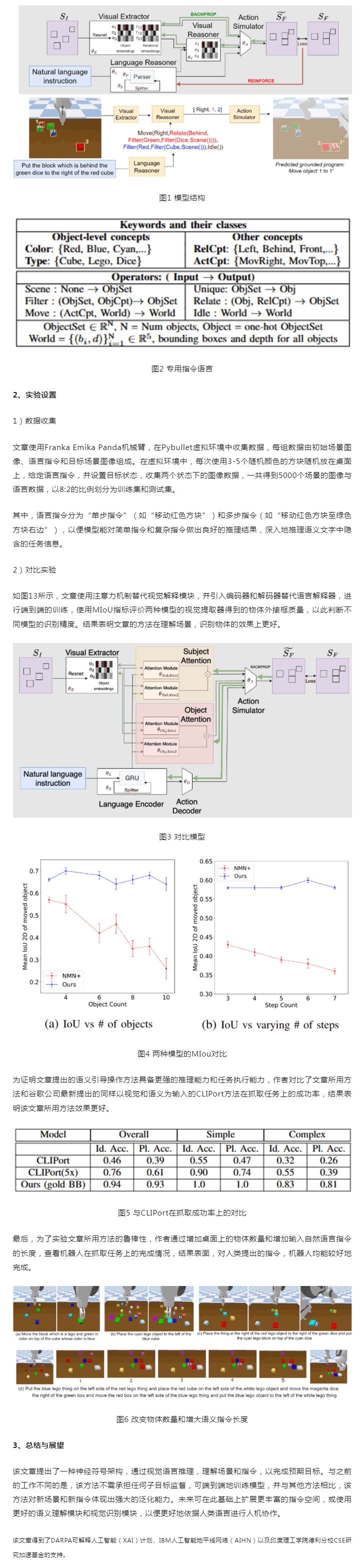

該端到端模型的結構如圖1所示,由視覺提取器、語言解釋器、視覺解釋器、動作模擬器組成。輸入初始場景和基于自然語言的任務指令,模型輸出完成該指令所需的動作參數,以及預測完成任務后的最終場景。

視覺提取器相當于一個目標檢測模型,用于識別初始場景下的物體信息。以圖11為例,輸入桌面初始狀態的圖像,視覺提取器輸出各個物體的外接框、顏色信息及物體名稱,并由外接框在桌面上的相對位置推斷物體的位置信息。

語言解釋器用于處理自然語言指令推理任務中隱含的操作動作。例如圖中“移動綠色骰子后面的紅色骰子至紅色方塊的右邊”這句指令,語言解釋器經過推理會得到完成該任務需要進行“移動”動作,移動的物體是“位于綠色骰子后面的紅色骰子”,目標是“紅色方塊右邊”,并可屏蔽“綠色方塊”和“藍色骰子”這些與完成任務無關的信息。推理完畢后,以專用指令集組合出推理結果。

專用指令集的結構如圖2所示,分為“關鍵詞”和“操作詞”,前者用于描述物體信息,后者用于表示操作信息。

視覺解釋器結合前二者輸出的場景信息和任務指令集,輸出完成該任務所需的參數化表示,交由任務模擬器生成機器人所能執行的動作參數,并預測完成任務后的場景情況。

以預測場景和數據集中提前設定好的目標場景做差,設置損失函數,即可實現端到端的訓練過程。

|

| 機器人底盤 Disinfection Robot 消毒機器人 講解機器人 迎賓機器人 移動機器人底盤 商用機器人 智能垃圾站 智能服務機器人 大屏機器人 霧化消毒機器人 紫外線消毒機器人 消毒機器人價格 展廳機器人 服務機器人底盤 核酸采樣機器人 機器人代工廠 智能配送機器人 噴霧消毒機器人 圖書館機器人 導引機器人 移動消毒機器人 導診機器人 迎賓接待機器人 前臺機器人 消殺機器人 導覽機器人 |